CRAWL BUDGET VOOR SEO VERHOGEN: 7 BEST PRACTICES

SEO lijkt soms oneerlijk, waarom komt Google niet gewoon vaker langs? Waarom zijn mijn nieuwe pagina’s nog niet geïndexeerd, maar wel gecrawld? Dat heeft alles te maken met jouw crawl budget. Wat is crawl budget, wat betekent het voor SEO en hoe verhoog ik mijn crawl budget? Dat alles vertellen we in dit artikel, plus een eigen case study!

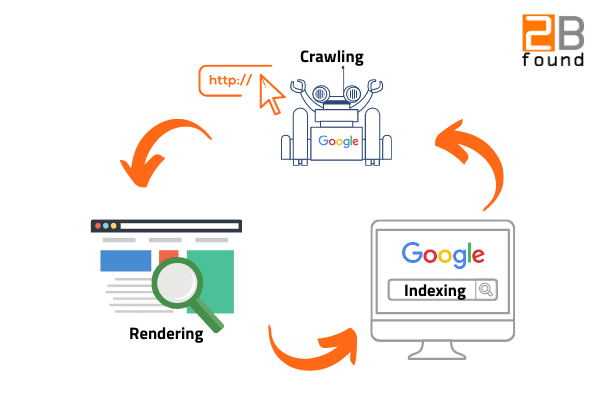

Om die vraag te beantwoorden, nemen we je eerst mee naar de manier waarop jouw website uiteindelijk in de zoekresultaten van Google belandt. Het begint namelijk allemaal bij crawling, ofwel het scannen van jouw webpagina’s door Googlebot.

Crawling is niet meer dan het afstruinen van alle links op jouw website, aan de hand waarvan Googlebot de grootte, diepte en linkstructuur van jouw website op waarde schat. Zodra Google jouw website heeft gecrawld, kan het rendering proces beginnen. Rendering is het proces waarmee Google de structuur en layout van jouw website probeert te begrijpen. Zodra het duidelijk is hoe jouw website is opgebouwd kan Google jouw pagina’s gaan indexeren. Ben je niet waardevol genoeg voor je bezoekers en/of is jouw content niet van genoeg kwaliteit? Dan word je misschien wel genegeerd door Google en behaal je dus geen rankings. Hieronder hebben we het proces visueel gemaakt.

Figuur 1: Crawling, rendering en indexering proces

Hoe vaak Google jouw website crawlt en hoeveel content Google tegelijk crawlt hangt af van je crawl budget. Super waardevol om daar inzicht in te krijgen dus! Jouw crawl budget verdelen we weer onder in crawl demand en je crawl rate. Beide bepaalt Google. De crawl demand geeft namelijk aan hoe vaak jouw content geüpdatet wordt en hoe ‘fris’ of actueel jouw content is. Neem een voorbeeld aan een nieuwssite en een website over de geschiedenis van Rome. Waar de nieuwssite minimaal dagelijks frisse, nieuwe content plaatst, zal de geschiedenis site niet snel haar content herzien. Dat zou ook een beetje gek zijn natuurlijk. Aan de hand daarvan bepaalt Google dan ook hoe vaak het ‘logisch’ is om jouw website te crawlen. Vervolgens bepaalt Google aan de hand van jouw crawl rate hoeveel jouw servers aankunnen tijdens het crawlen. Letterlijk namelijk het aantal verzoeken (requests) per seconde. Met andere woorden, hoe goed kan je die activiteit van de Googlebot aan?

Enerzijds wil Google dus graag zoveel mogelijk informatie crawlen binnen jouw website, omdat het mogelijk relevant is voor haar bezoekers. Anderzijds wil Google jouw servers niet te veel belasten, om niks te laten crashen. Die mate van belastbaarheid van jouw server wordt sterk beïnvloed door bijvoorbeeld jouw website snelheid. Een trage website verdient zo ook een lager crawl budget. Google heeft immers ‘wel betere dingen te doen’. Onthoud wel: niet elke website moet ook een ‘hoog’ crawl budget willen hebben.

“Als je niet dagelijks content updatet, waarom wil je dan dat we jouw website dagelijks crawlen?” – Martin Splitt, Google

Nu denk je misschien, waarom is crawl budget dan belangrijk? Ondanks dat crawl budget niet voor iedere site van belang is, heeft het wel degelijk meerdere voordelen voor iedere website om je ermee bezig te houden. We lichten ze dan ook hieronder uit.

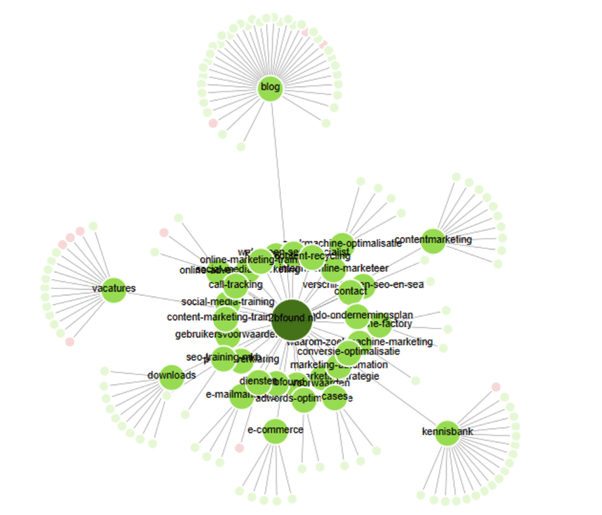

Figuur 2: Crawl issues oplossen binnen je website

Zodra je merkt dat je crawl budget aanzienlijk is gekrompen, is het goed om te onderzoeken wat er aan de hand is. Binnen SEO hangt niet voor niets alles aan elkaar vast en via je crawl budget kan je zo bijvoorbeeld crawl issues achterhalen. Crawlt Google opeens aanzienlijk minder pagina’s? Dan kun je direct analyseren wat dat betekent voor je website. Heeft het invloed op belangrijke pagina’s binnen je website? Dan kun je direct aan de bel trekken. Naast dat je met die issues je crawl budget weer de lucht in kunt schieten, is het natuurlijk een manier om je website te verbeteren en fouten op te lossen. Zometeen meer over onze best practices en een eigen test case.

We luidden hem net al in, door fouten op te lossen en issues te verhelpen via je crawl budget analyse kan je jouw website gezond houden. Door je crawl budget te optimaliseren, zorg je ervoor dat Google eenvoudig door je website heen navigeert en jouw belangrijkste pagina’s ontdekt én indexeert. Alle activiteiten die bijdragen aan het verhogen van je crawl budget dragen daarmee bij aan jouw SEO strategie.

Extra: de meeste websites waar actief aan gewerkt wordt, bouwen vaak vanzelf een gezond crawl budget op. Het is dan ook geen doel op zichzelf om het grootste crawl budget van Nederland te hebben. John Muller bevestigt in onderstaande tweet dat veel websites zich geen zorgen moeten maken om crawl budget.

We render pretty much everything that we index, so if you submit it for indexing, we’ll likely render it too. Also, these don’t change anything for crawl budget (and most sites don’t need to worry about crawl budget anyway).

— ???? John ???? (@JohnMu) September 22, 2019

Door aandacht te besteden aan het optimaliseren van je crawl budget dwing je jezelf wel om eens goed aan de achterkant van SEO te kijken. Hoe zit mijn website technisch in elkaar? Heeft Google problemen met crawling? Waarom maak ik het ze moeilijk? Daarvoor hebben we onderstaand 7 best practices voor je uitgezet, waarmee je jouw crawl budget kunt verhogen en je Google een handje helpt.

“Je kan Google alleen vragen je website minder vaak te crawlen, niet meer!”

Maak het crawl proces van Google zo efficiënt mogelijk. Wat daar zeker niet aan bijdraagt, is het omleiden van links en het breken van interne links. Het omleiden van links noemen we ook wel redirect chains, wat letterlijk dus staat voor een ellenlange ketting van bestemmingen van links. Via een link wil je direct verwijzen naar de juiste bestemmingspagina. Zodra 301 redirects worden geplaatst op de bestemmings URL wordt de Googlebot dus omgeleid. Dat vertraagt de crawling. Een ander scenario is dat een link geen bestemming meer heeft, oftewel dat er een 404 status code wordt geserveerd. Zorg dus dat je interne linkprofiel op orde is!

Een trage website zorgt ervoor dat je het crawl proces vertraagt. Dat gaat ten kosten van je crawl budget. Dat wordt voornamelijk een probleem als niet alle belangrijke pagina’s gecrawld kunnen worden of als Google vaker langs moet komen dan nu gebeurt. Gooi jouw URL eens in de pagespeed tool van Google en bepaal of hier een probleem ligt voor jouw website.

De structuur van jouw website bepaalt waar belangrijke pagina’s en minder belangrijke pagina’s een plek krijgen binnen de website. Naast dat jouw structuur altijd logisch onderverdeeld moet zijn, is het belangrijk om de structuur niet te diep te maken. Een platte, duidelijke website structuur heeft een positief effect op de crawling van jouw website.

Figuur 3: Structuurdiepte 2Bfound – Screaming Frog

Eén van de best practices om Googlebot juist aan de hand te nemen tijdens crawling is het actualiseren van je XML sitemap. Zorg dat Google niet voor verrassingen komt te staan en zorg dus dat nieuwe en belangrijke pagina’s goed worden opgenomen in je sitemap. Een geüpdatete sitemap geeft een signaal van actualiteit en relevantie van jouw website.

Laat Googlebot geen tijd verspillen aan pagina’s die niet geïndexeerd moeten worden. Maak daarom juist gebruik van canonical tags en zorg dat je de juiste signalen afgeeft aan Google. Voor meer hierover duik je in onze canonical tag gids! Tipje van de sluier: een canonical tag zou op iedere pagina van je website moeten staan en verwijst naar de originele URL.

Deze best practice is met name interessant voor webshops. Die hebben namelijk vaak te maken met tags en URL parameters. Waar de tags en parameters voor gebruikers heel vriendelijk kunnen werken, is het wel verstandig om ook Googlebot op de juiste manier in te lichten. Tags en parameters kunnen namelijk voor duplicate content zorgen. Elke URL wordt namelijk behandeld als een afzonderlijke pagina. Een goede manier om dat recht te zetten is het crawl pad naar die parameters en tags uit te sluiten via je robots.txt. Dit is ook mogelijk voor bots van tools die je vaak gebruikt en bedankt pagina’s.

Extra: misschien heb je al wel eens van de URL-tool van Google Search Console gehoord, om via die weg parameters uit te sluiten. Gebruik deze echter alleen als er echt al meer dan 1000 van die pagina’s zijn geïndexeerd. Don’t fix what isn’t broken.

Tot slot is het goed om te inventariseren of je verkeerde signalen afgeeft, zoals tegengestelde redirects en canonicals. De bezoeker verwijs je met een redirect naar een andere, juiste pagina. Op de originele pagina wil je dus geen zelfverwijzende canonical hebben. Een simpel voorbeeld: “Ik wil dat je dat wel niet doet”. Ja, inderdaad, zo voelt Google dat ook!

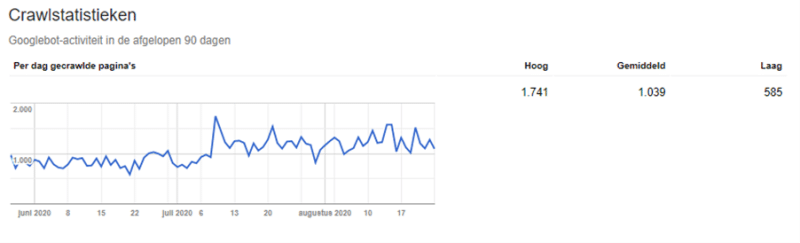

Ben je benieuwd hoe hoog jouw crawl budget is? Er is nog altijd een, inmiddels wat verouderde tool van Google Search Console beschikbaar! Ga er direct heen via deze link: GSC crawlstatistieken tool.

Natuurlijk testen we als SEO bureau zelf ook welke factoren de meeste invloed hebben op jouw crawl budget. Hieronder zie je onze crawl budget test, waarbij we de redirect chains flink onder handen hebben genomen. Het aantal gecrawlde pagina’s is zichtbaar toegenomen (zeker 200 pagina’s per dag).

Figuur 4: Crawl budget optimalisatie 2Bfound

Neem eenvoudig contact met ons op voor al je vragen en/of volg ons op LinkedIn, Facebook en Instagram om op de hoogte te blijven van meer interessante topics en trends.